ML参数及ResNet中Pre-activation和post-activation的区别

发布日期:2022-02-17 04:52:20

浏览次数:11

分类:技术文章

本文共 561 字,大约阅读时间需要 1 分钟。

batch_size:多少个数据为一个批次进行梯度更新。

batch:以batch_size为单位,将数据集划分为多少个batch。batch=total size/batch_size

epoch:将整个数据集训练多少次。一般选择>1,因只输入网络一次不能很好的学习到特征。

shuffle:每个epoch是否乱序;

max_seq_len:tokenizer参数,若数据大于max_seq_len,直接截断;少于max_seq_len时,在输入网络时,会padding 0,进行数据的对齐

tqdm库:在电脑终端上显示进度,使代码进度可视化,用于for循环中。

辅助标记符[CLS]和[SEP]来表示句子的开始和分隔。

pytorch:数据读取Dataloader

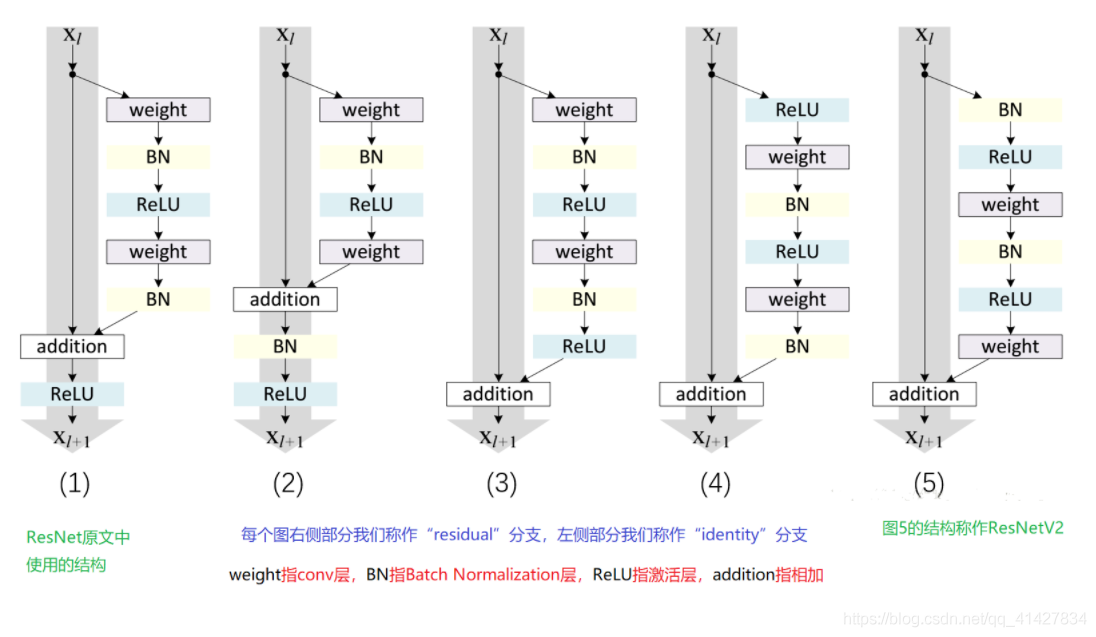

ResNet中Pre-activation和Post-activation的区别

其中pre和post是对于卷积操作来说的, 对于1,2,3是先进行卷积,故为post-activation

4,5为pre-activation模式;

shortcut可以理解为跨层连接,为了减轻随着网络深度的增加,模型性能降低的问题。

下采样(downsampling)可以用于减少模型参数,如DPCNN中,选取步长为2,大小为3的下采样,可以是特征图数据量减少一半。

转载地址:https://blog.csdn.net/qq_41427834/article/details/116349469 如侵犯您的版权,请留言回复原文章的地址,我们会给您删除此文章,给您带来不便请您谅解!

发表评论

最新留言

能坚持,总会有不一样的收获!

[***.219.124.196]2024年04月25日 08时42分27秒

关于作者

喝酒易醉,品茶养心,人生如梦,品茶悟道,何以解忧?唯有杜康!

-- 愿君每日到此一游!

推荐文章

WEB攻击手段及防御第3篇-CSRF

2019-04-28

WEB攻击手段及防御-扩展篇

2019-04-28

spring bean初始化及销毁你必须要掌握的回调方法。

2019-04-28

mysql语句性能开销检测profiling详解

2019-04-28

hashCode到底有什么用?

2019-04-28

设计模式之动态代理模式实战

2019-04-28

设计模式之静态代理模式实战

2019-04-28

作为架构师,你必需要搞清楚的概念:POJO、PO、DTO、DAO、BO、VO

2019-04-28

mysql查询优化explain命令详解

2019-04-28

常用加密算法解析

2019-04-28

设计模式之单例模式实践

2019-04-28

彻底理解正向代理和反向代理

2019-04-28

一次频繁Full GC的排查过程,根源居然是它...

2019-04-28

Unicode与UTF-8的区别

2019-04-28

最长回文子串(Longest Palindromic Substring)

2019-04-28

Windows 通过 SecureCRT 8.x 上传文件到Linux服务器

2019-04-28

Spring MVC的GET与POST请求url-pattern坑

2019-04-28

<table/>默认适应内容宽度造成滚动条不显示的解决方法

2019-04-28

【爬虫】简单十行代码爬取B站的B站弹幕

2019-04-28

leetcode 刷题108109

2019-04-28