机器学习:支持向量机

发布日期:2021-07-01 04:10:24

浏览次数:2

分类:技术文章

本文共 596 字,大约阅读时间需要 1 分钟。

支持向量机

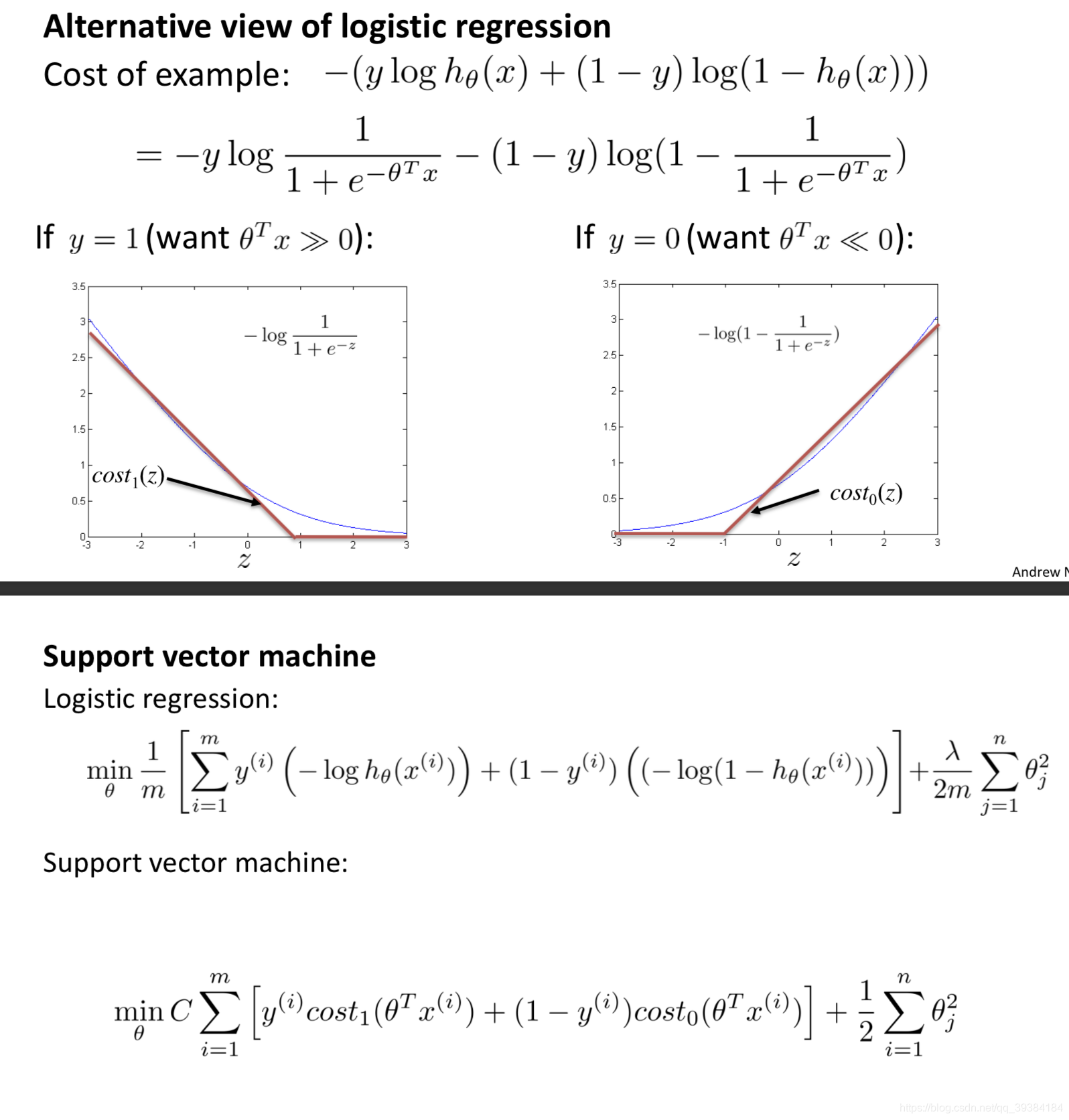

优化目标

与逻辑回归相似。

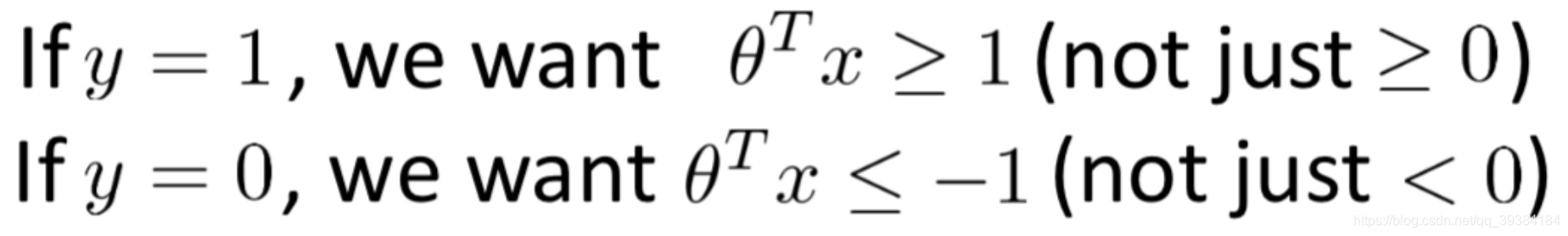

直观上对大间隔的理解

要想优化损失函数,不仅需要大于 0,更需要大于 1 才可以。

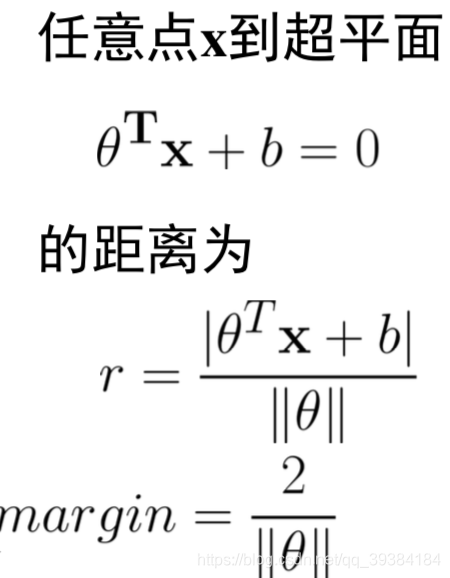

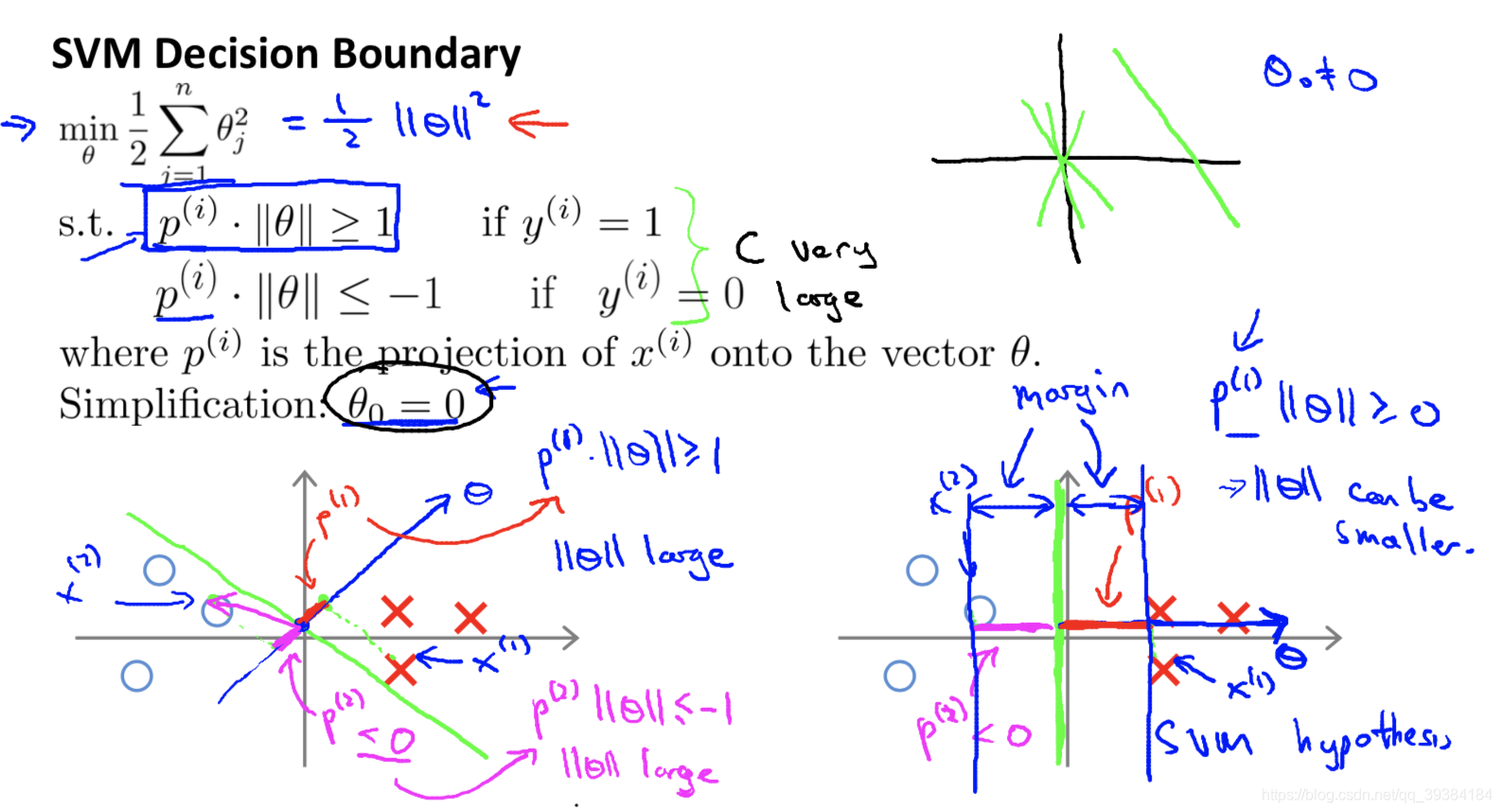

大间隔的数学原理

间隔越大,X 到 θ 的投影越大,损失函数越小。

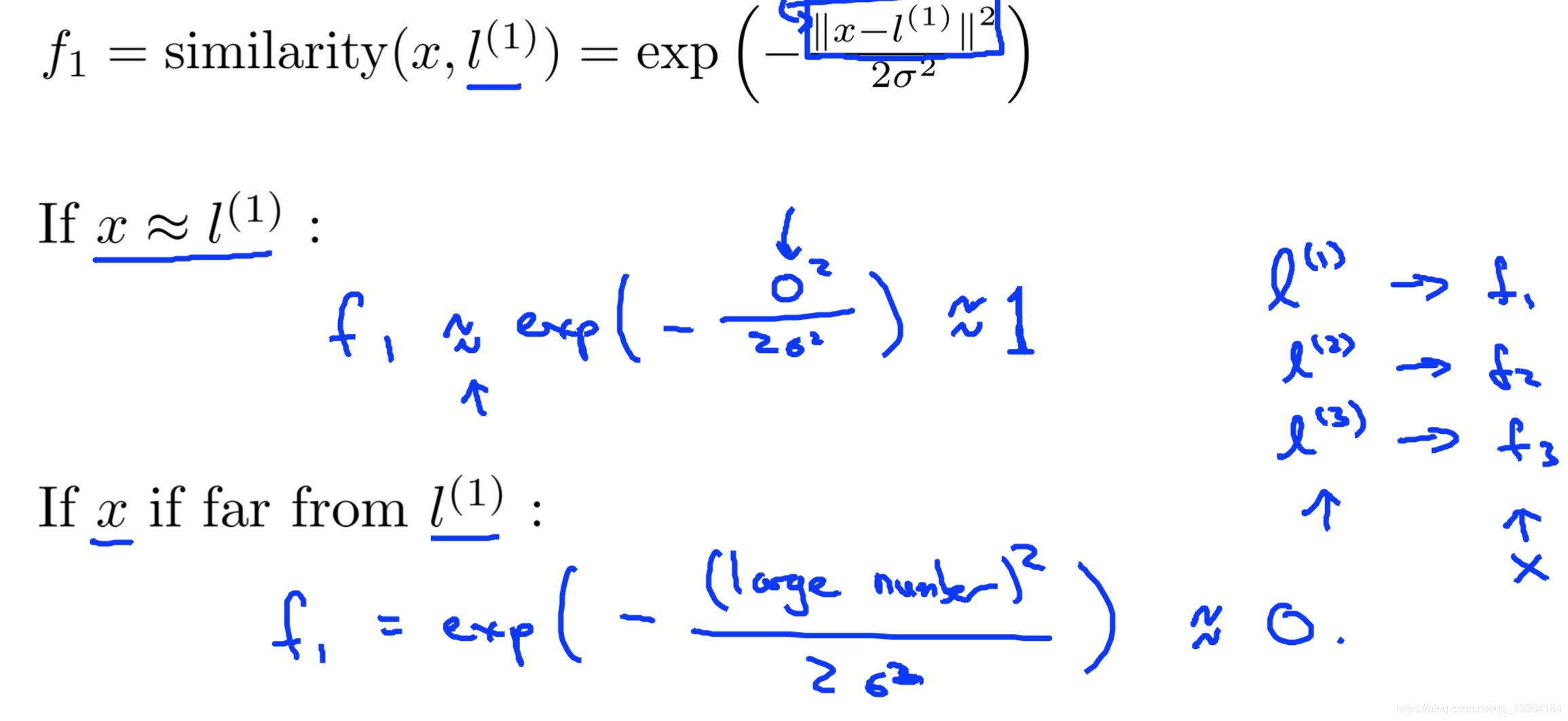

核函数

- 选择标记点(样本)

- 高斯核函数

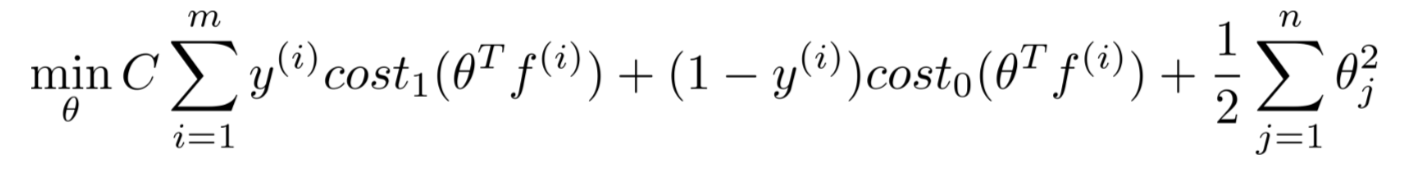

- 使用核函数的 SVM 的损失函数

偏差方差折中

C=1/λ

- C 越大:高偏差,低方差(过拟合)

- C 越小:低偏差,高方差(欠拟合)

σ^2

- σ^2 越大,f 越平缓,高偏差,低方差(过拟合)

- σ^2 越小,f 不平缓,低偏差,高方差(欠拟合)

使用 SVM

- 选择 C

- 选择核函数(符合默瑟定理,Mercer’s Theorem)

- 高斯核函数

- 线性核函数(无核函数)

- 多项式核函数

- 字符串核函数

- 卡方核函数

- 直方相交核函数

SVM 和逻辑回归的选择

N 个特征,M 个样本

- N 对于 M 很大:逻辑回归或者无核 SVM

- N 很小,M 适中:高斯核 SVM

- N 很小,M 很大:增加更多的特征,然后使用逻辑回归或者无核 SVM

SVM 不需要解决局部最优的问题,神经网络可以解决几乎所有的问题,但是训练速度比 SVM 慢。

其他

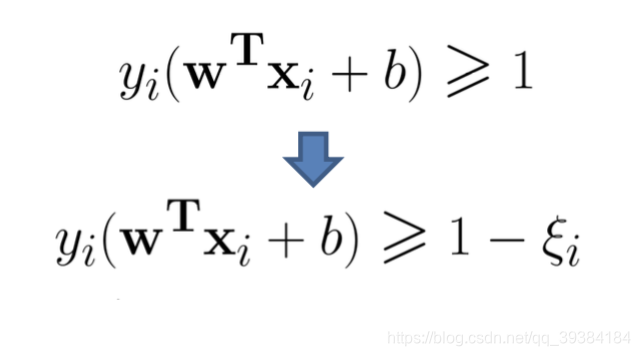

- 软间隔的 SVM

对于线性不完全可分的情况,引入软间隔的SVM,即允许某些样本不满足约束。

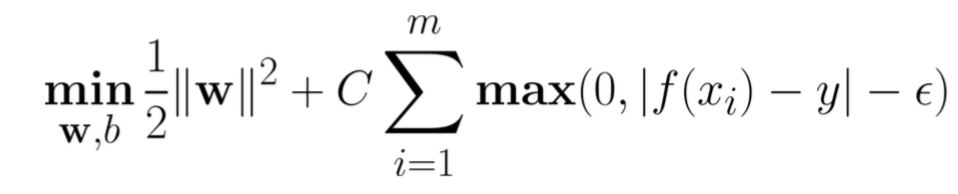

- 支持向量回归 SVR

传统回归:f(x)与y完全相等时损失为0;

SVR: f(x)与y的差异大于一定值时才计算损失,落入间隔带中不计算损失。

转载地址:https://mortal.blog.csdn.net/article/details/91555822 如侵犯您的版权,请留言回复原文章的地址,我们会给您删除此文章,给您带来不便请您谅解!

发表评论

最新留言

留言是一种美德,欢迎回访!

[***.207.175.100]2024年04月24日 23时30分36秒

关于作者

喝酒易醉,品茶养心,人生如梦,品茶悟道,何以解忧?唯有杜康!

-- 愿君每日到此一游!