如何在jupyter notebook裡運行Spark及Scala

发布日期:2021-05-06 19:48:53

浏览次数:22

分类:原创文章

本文共 584 字,大约阅读时间需要 1 分钟。

如何在jupyter notebook裡運行Spark及Scala

前言

本篇譯自:,文中介紹了從安裝套件、創建Kernel spec,到啟動jupyter notebook及測試Scala程式的完整流程。

安裝套件

pip install spylon-kernel創建Kernel spec

原文中並沒有說明Kernel spec是什麼,到查詢後,個人將之理解為每個kernel的id。

python -m spylon_kernel install經過這一步以後,我們就可以在notebook中選擇scala當作kernel。

啟動jupyter notebook

ipython notebook #or jupyter notebook接著在jupyter notebook起始畫面中選擇New -> spylon-kernel,

測試Scala

我們可以看到它啟動了SparkContext跟SparkSession。

我們可以看到它啟動了SparkContext跟SparkSession。

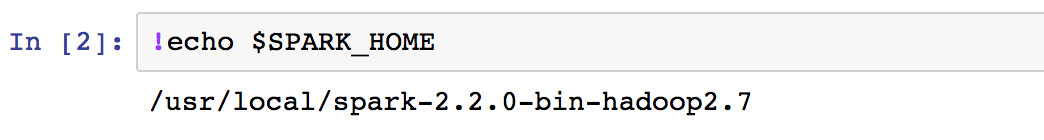

如果執行失敗,請使用以下指令檢查SPARK_HOME這個環境變量是否存在。

接著可以來創建一個dataset:

如果想要執行python也是辦得到的,只要在當前cell最前面加上%%python即可:

如果想要更了解spylon-kernel可以拜訪他們的Github網頁:。

文章中用到的notebook則可以在找到。

參考連結

发表评论

最新留言

第一次来,支持一个

[***.219.124.196]2025年04月12日 19时48分09秒

关于作者

喝酒易醉,品茶养心,人生如梦,品茶悟道,何以解忧?唯有杜康!

-- 愿君每日到此一游!

推荐文章

Highgo Database故障收集脚本

2021-05-08

failed to initialize the database

2021-05-08

invalid byte sequence for encoding

2021-05-08

银河麒麟系统配置apt网络源

2021-05-08

第七周 4.12-4.18

2021-05-08

程序设计入门14 结构体

2021-05-08

程序设计基础75 tips 广度搜索细节问题

2021-05-08

笨办法学python之数据类型

2021-05-08

笨办法学Python之将对象名的字符串类型,转化成相应对象

2021-05-08

ArduPilot源码极速下载手册(一文告别github慢速问题)

2021-05-08

聊一聊那些应该了解的大佬(飞控,人工智能方向)

2021-05-08

ArduPilot+mavros+gazebo+QGC联合仿真初体验

2021-05-08

px4调试bug--添加mavlink_log_info信息

2021-05-08

redis替换字符串命令

2021-05-08

redis向数组中添加值并查看数组长度

2021-05-08

python3基础梳理11python中模块和包

2021-05-08

JS编写一个函数,计算三个不同数字的大小,按从小到大顺序打印(穷举法)

2021-05-08

mybatis中like的注意

2021-05-08

sqlplus的基本使用

2021-05-08

oracle删除表重复数据

2021-05-08