本文共 4976 字,大约阅读时间需要 16 分钟。

闲扯几句

大家好,本期我准备了一篇爬虫的教程,也是从最基础的网页爬虫开始,给大家讲讲网页爬虫的小技巧。

看到网上很多的爬虫代码都是基于python的,那作为一名Java工程师的我就有点不服气了,Java难道不能做爬虫吗?我想写个爬虫是不是还得先学会python?程序员的头发不知道多宝贵吗?花那么多时间学习语言,是想造孽啊?救救孩子吧,救救我我本来就日渐稀疏的头发吧。

我命由我不由天,我今天就自己来试试看,看看Java写个爬虫是有多费劲?看懂的朋友别忘记给我个三连哈,毕竟我是堵上了咱们Java程序员的荣誉在奋战!奥利给!

网页分析

话不多说,开整!

先打开我要爬取数据的网页:豆瓣电影Top250

我们先来分析一下这个网页,看看哪些数据比较有价值。

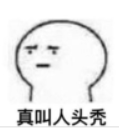

以「No.1」的经典越狱电影《肖申克的救赎》举例子,我们可以看到的数据有:排名

电影名称

导演和演员信息

电影上映年份

电影所属的国家

电影类型

电影评分

电影评价数

电影简评

OK,分析完一个网页结构,确定好了我们需要的数据,那么我们准备开始写程序批量抓取了。

思路讲解

写代码之前,我们先不要着急,先理一理思路。你知道,写代码最重要的就是思路,思路理顺了,可以说你的代码已经完成了一半。那剩下的一半干嘛?写bug,调bug呗🤣

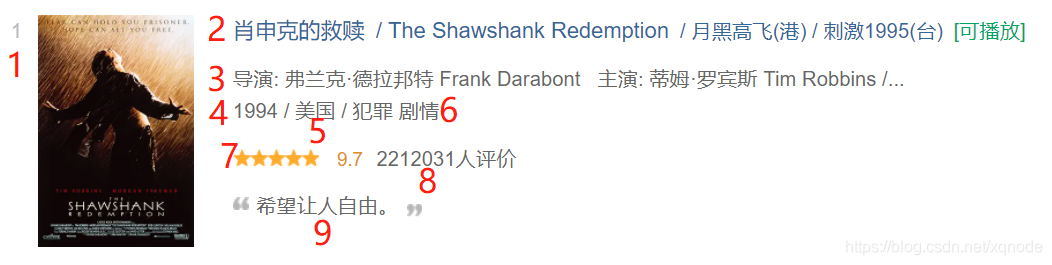

打开网页豆瓣电影Top250按下 「f12」,看到下面这个界面

我们一起来分析一下数据,讲一讲怎么抓取。

点击左上角这个箭头,然后选中网页对应的位置,在下面就会出现这个位置对应的html代码。

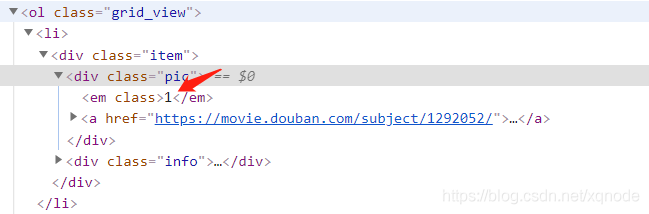

先整体看一下,可以看到每个电影都是一个

标签,在这个li标签里面存放着这个电影相关的全部html代码:

再打开li标签,可以看到,每个li标签里面都是一个 class='item'的div,这个div就是我们需要获取数据的最外层div了。然后我们从这个div往下看,找到对应数据存放的标签即可。

比如这个电影排名:

我们可以从下面的 em 标签里面找到,那我们只需要一层层往下解析这个html代码,找到这个 em标签,获取出里面的文本就行了。其他的数据也是异曲同工,我们可以按照这个套路都找一下对应的标签的位置,然后抓取。

怎么样,很简单是吧?那么下面就开始写bug吧

撸代码

写代码之前先喝杯咖啡,润润肺,找找灵感,你知道5k程序员和50k程序员的差别在哪里吗?

仪式感!我跟你说,仪式感非常重要,包括生活中也是,你不能把自己过成穷屌丝的样子,要不然这辈子抬不起头来,你要假装自己是亿万富翁,然后花钱去享受,再然后回到一穷二白。如果你非要问我为什么要有这段经历,那不就是死要面子活受罪么...

咳咳,扯远了,继续回到正题哈。

我这次使用的插件是 Jsoup,相信很多小伙伴都听说过它的大名啊,没错,它是一个非常适合做网页html解析的第三方类库,而且它可以直接连接目标网址,获取数据,无需使用其他的http请求工具,非常的方便,适合小白。

第一步:创建maven工程

为什么使用maven工程?

那还用问啊,当然是方便啊,我总不能去网上下载jar包导进idea吧,那太low了,不符合我的气质啊,所以你自己拿捏了哈,同学。

创建maven工程具体的步骤我就不在这里赘述了,网上教程一搜一大堆。我们创建好工程后直接在pom里导入依赖:

org.jsoup

jsoup

1.13.1

对,是她了,我们的主角jsoup。

接下来就开始撸了呗。因为我们请求的所有数据分为10页,所以我们写个循环,从0开始:

第一页的url是这样的:https://movie.douban.com/top250?start=0&filter=

第二页的url是这样的:https://movie.douban.com/top250?start=25&filter=

可以看出来,通过start 这个参数可以控制切换分页,那么我们就在循环里制造这样的参数:

for (int i = 0; i

int page = i * 25; // 制造分页参数

}

下面就开始通过Jsoup发送http请求获取网页html代码,这里的document就是整个文档对象,我们可以从中获取各种标签的数据。

Document document = Jsoup.connect("https://movie.douban.com/top250?start="+ page).get();

拿到文档对象后,我们就获取每个电影的div,分析网页可以看到,它的class是item

所以我们通过getElementsByClass方法批量从网页中获取class=item的元素:

Elements items = document.getElementsByClass("item"); // 批量获取当前页中class=item的元素

然后开始遍历所有的item,依次获取他们的电影相关的数据:

for (Element item : items) {

// 每个item中都包含当前电影的所有数据

}

再来分析网页,依次拿到我们需要的数据「电影排名」 很简单啊,直接获取item中第一个em标签的文本就可以了:

很简单啊,直接获取item中第一个em标签的文本就可以了:

String num = item.getElementsByTag("em").get(0).text();「电影名称」 获取item 下的第一个class=hd div的第一个span的文本

获取item 下的第一个class=hd div的第一个span的文本

String title = item.getElementsByClass("hd").get(0).getElementsByTag("span").get(0).text();「演员信息、电影年份、国家、电影类型」 注意这里,演员信息在一个p标签里,但是p标签的文本分成了两部分,用

注意这里,演员信息在一个p标签里,但是p标签的文本分成了两部分,用

String bd = item.getElementsByClass("bd").get(0).getElementsByTag("p").get(0).html();

String actor = bd.split("

")[0].replaceAll(" ", " "); // 演员信息,注意替换空格符号String info = bd.split("

")[1].replaceAll(" ", " ");String[] infos = info.split("/"); // 下面的三个数据通过 '/' 来分割

String year = infos[0].trim(); // 电影年份

String country = infos[1].trim(); // 国家

String type = infos[2].trim(); // 电影类型「电影评分」 这个就比较简单了,直接获取第一个 class=rating_num 标签的文本就可以了:

这个就比较简单了,直接获取第一个 class=rating_num 标签的文本就可以了:

String ratingNum = item.getElementsByClass("rating_num").get(0).text(); // 获取评分「电影简评」 这个跟评分类似,获取第一个 calss=quote 标签的文本就可以了:

这个跟评分类似,获取第一个 calss=quote 标签的文本就可以了:

String quote = item.getElementsByClass("quote").get(0).text();

Ok,到这里所有的代码就写完了,怎么样,是不是跟着思路走分析起来很容易呢?你自己可以试试哦,这里是完整的代码:

for (int i = 0; i

int page = i * 25;

Document document = Jsoup.connect("https://movie.douban.com/top250?start="+ page).get();

Elements items = document.getElementsByClass("item");

for (Element item : items) {

String num = item.getElementsByTag("em").get(0).text();

String title = item.getElementsByClass("hd").get(0).getElementsByTag("span").get(0).text();

String bd = item.getElementsByClass("bd").get(0).getElementsByTag("p").get(0).html();

String actor = bd.split("

")[0].replaceAll(" ", " ");String info = bd.split("

")[1].replaceAll(" ", " ");String[] infos = info.split("/");

String year = infos[0].trim();

String country = infos[1].trim();

String type = infos[2].trim();

String ratingNum = item.getElementsByClass("rating_num").get(0).text();

String quote = item.getElementsByClass("quote").get(0).text();

System.out.println("电影名次: " + num);

System.out.println("电影标题: " + title);

System.out.println("电影演员: " + actor);

System.out.println("电影年份: " + year);

System.out.println("国家: " + country);

System.out.println("电影类型: " + type);

System.out.println("电影评分: " + ratingNum);

System.out.println("电影简评: " + quote);

System.out.println("============================================");

}

}

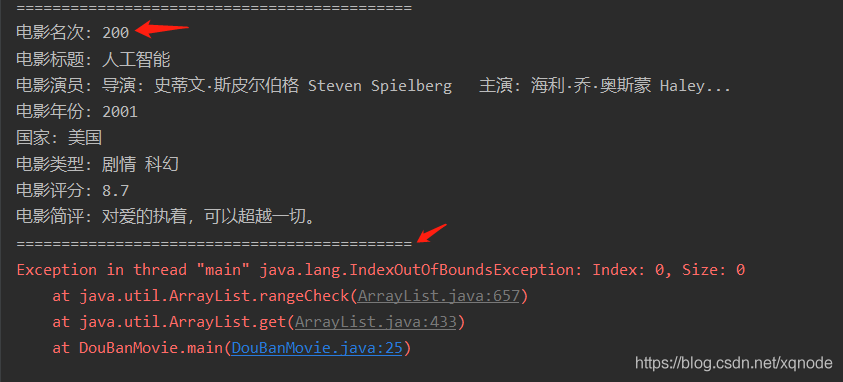

写完之后,我们运行一下代码,看看代码有没有问题。

果然,出问题了,哈哈哈,很快哈,啪的一下就出来了。

这是个啥错误?

一看,数组越界了,我心中已经猜想到答案了,肯定是获取的数据缺少了点什么导致的。我们定位到问题行:25,也就是这段代码:

String quote = item.getElementsByClass("quote").get(0).text();

获取简评失败了。

再看是第几个电影的数据出问题:

第200个电影是好的,那就是说它的下一个 201 出问题了。我们翻到这一页看下网页是啥样的:

果然,这个名叫 哈利·波特与火焰杯 的电影没有简介,那就是说没这个标签啊,怪不得获取失败了。

那咋办呢?我们这里就需要对异常信息进行一个处理,不能让程序中断。

String quote = "";

if (item.getElementsByClass("quote").size() > 0) {

quote = item.getElementsByClass("quote").get(0).text();

}

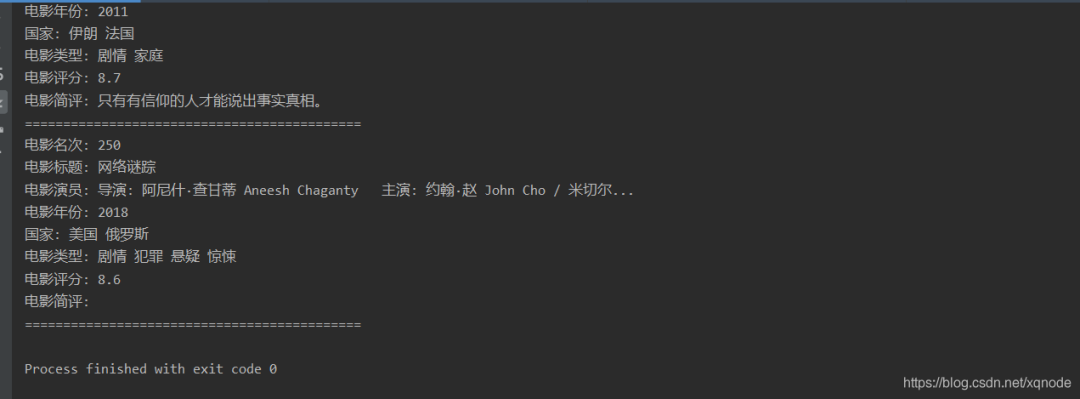

再跑一次:

程序完整运行下来了,而且电影信息全部拿到了,也就是说我们这次关于豆瓣电影 top250的数据爬取成功了。

结尾

好了,以上就是我这期给您带来的一个Java爬虫入门小案例。从需求分析到思路整理再到代码细节、错误处理,整个过程都非常详细充实,并且代码执行的每一步都配置了图片说明,就是为了能让你真正搞懂。你说,我是不是个贴心的大暖男🥰

希望通过我分享的案例能带你一起学习、提升,发现更多有趣好玩儿的东东

喜欢的记得三连哦~

转载地址:https://blog.csdn.net/weixin_33443932/article/details/114612446 如侵犯您的版权,请留言回复原文章的地址,我们会给您删除此文章,给您带来不便请您谅解!

发表评论

最新留言

关于作者