本文共 12714 字,大约阅读时间需要 42 分钟。

什么是散列表

散列思想

散列表的英文叫“Hash Table”,我们平时也叫它“哈希表”或者“Hash 表”。散列表用的是数组支持下标随机访问的特性,所以散列表其实就是数组的一种扩展,由数组演化而来。可以说,没有数组就没有散列表

例子1

假如我们有89名选手参见学习运动会。为了方便记录成绩,每个选手胸前都会贴上自己的参赛号码。这 89 名选手的编号依次是 1 到 89。现在我们希望编程实现这样一个功能,通过编号快速找到对应的选手信息。那该怎么做呢?

- 我们可以把这89名选手的信息放在数组里。编号为1的选手,我们放到数组中下标为1的位置;编号为2的选手,放到数组中下标为2的位置。以此类推,编号为k的选手放到数组中下标为k的位置

- 因为参赛编号跟数组下标一一对应,当我们需要查询参赛编号为x的选手的时候,我们只需要将下标为x的数组元素取出来就可以了,时间复杂度为O(1)。

实际上,这个例子已经用到了散列的思想。在这个例子里,参赛编号是自然数,并且与数组的下标形成一一映射,所以利用数组支持根据下标随机访问的时候,时间复杂度是 O(1) 这一特性,就可以实现快速查找编号对应的选手信息。

例子2

还是上面例子,但是编号的规则用 6 位数字来表示。比如 051167,其中,前两位 05 表示年级,中间两位 11 表示班级,最后两位还是原来的编号 1 到 89。这个时候我们该如何存储选手信息,才能够支持通过编号来快速查找选手信息呢?

- 尽管我们不能直接把编号作为数组下标,但我们可以截取参数编号为后两位作为数组下标,来存取选手信息数据。

- 当通过参数编号查询选手信息的时候,我们用同样的方法,取参数编号的后两位,作为数组下标,来读取数组中的数据。

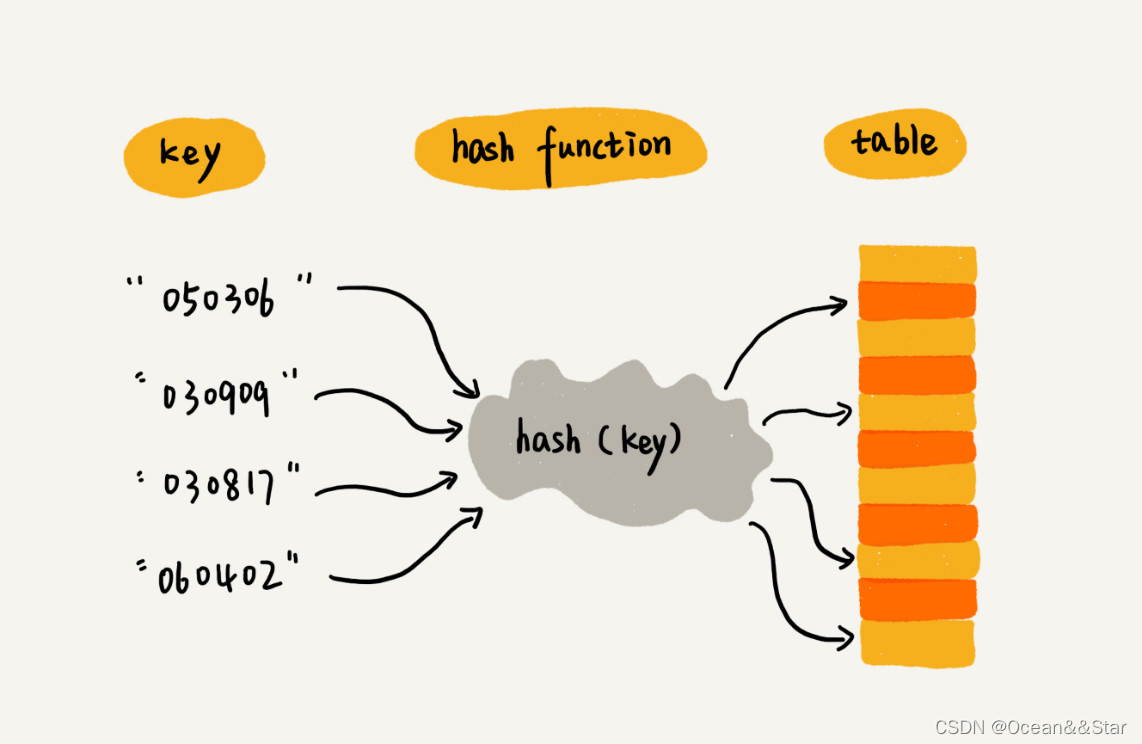

这就是典型的散列思想。其中,参赛选手的编号我们叫作键(key)或者关键字。我们用它来标识一个选手。我们把参赛编号转化为数组下标的映射方法就叫作散列函数(或“Hash函数”“哈希函数”),而散列函数计算得到的值就叫作散列值(或“Hash 值”“哈希值“)

- 散列表用的就是数组支持下标随机访问的时候,时间复杂度是O(1)的特性

- 我们通过散列函数把元素的键值映射为下标,然后将数据存储在数组中对应下标的位置

- 当我们按照键值查询元素时,我们用同样的散列函数,将键值转换成数组下标,从对应的数组下标的位置读取数据

散列函数

散列函数,顾名思义,它是一个函数。我们可以把它定义成hash(key),其中 key 表示元素的键值,hash(key) 的值表示经过散列函数计算得到的散列值。

那该如何构造散列函数呢?一个散列函数,应该满足下面三个要求:

- 散列函数计算得到的散列值是一个非负整数: 因为数组下标是从 0 开始的,所以散列函数生成的散列值也要是非负整数。

- 如果 key1 = key2,那 hash(key1) == hash(key2):相同的 key,经过散列函数得到的散列值也应该是相同的。

- 如果 key1 ≠ key2,那 hash(key1) ≠ hash(key2)。

- 这个要求看起来合情合理,但是在真实的情况下,要想找到一个不同的key对应的散列值都不一样的散列函数,几乎是不可能的

- 即便像业界著名的MD5、SHA、CRC等哈希算法,也无法完全避免这种散列冲突。而且,因为数组的存储空间有限,也会加大散列冲突的概率

- 所以我们几乎无法找到一个完美的无冲突的散列函数,即便能找到,付出的时间成本、计算成本也是很大的,所以针对散列冲突问题,我们需要通过其他途径来解决

散列冲突

再好的散列函数也无法避免散列冲突。那究竟该如何解决散列冲突问题呢?我们常用的散列冲突解决方法有两类,开放寻址法(open addressing)和链表法(chaining)。

开放寻址法

开放寻址法的核心思想是,如果出现了散列冲突,我们就重新探测一个空闲位置,将其插入。

那如何重新探测新的位置呢?有很多方法

线性探测

当我们往散列表中插入数据时,如果某个数据经过散列函数散列之后,存储位置已经被占用了,我们就从当前位置开始,依次往后查找,看是否有空闲位置,直到找到为止。

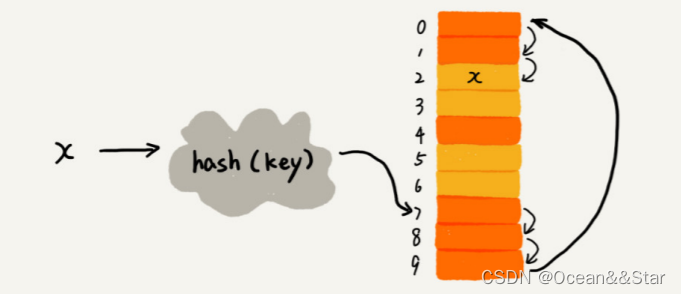

举个例子,下面图中黄色的色块表示空闲位置,橙色的色块表示已经存储了数据。

在散列表中插入一个数据:

- 从图中可以看出,散列表的大小为10,在元素x插入到散列表之前,已经有6个元素插入到散列表中

- x经过hash算法之后,被散列到位置下标为7的位置,但是这个位置已经有数据了,所以就产生了冲突。

- 于是我们就顺序的往后一个一个找,看有没有空闲的位置,遍历到尾部都没有找到空闲的位置,于是我们再从表头开始找,直到找到空闲位置2,于是将其插入到这个位置。

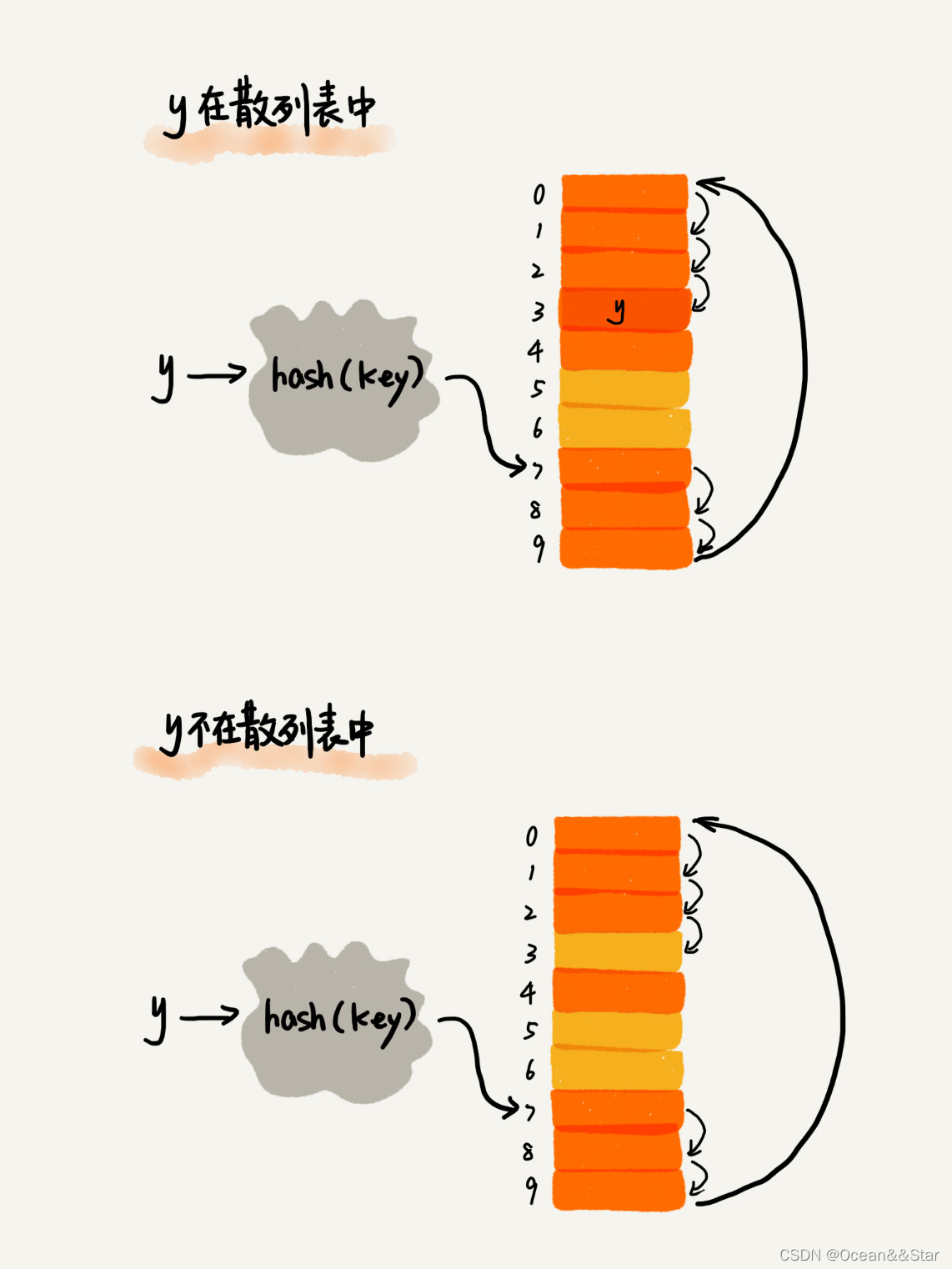

在散列表中查找一个数据:

- 我们通过散列函数求出要查找元素的键值对应的散列值,然后比较数组中下标为散列值的元素和要查找的元素

- 如果相等,则说明就是我们要找的元素

- 如果不相等,就顺序往后查找。如果遍历到数组中的空闲位置,还没有找到,就说明要查找的元素并没有在散列表中

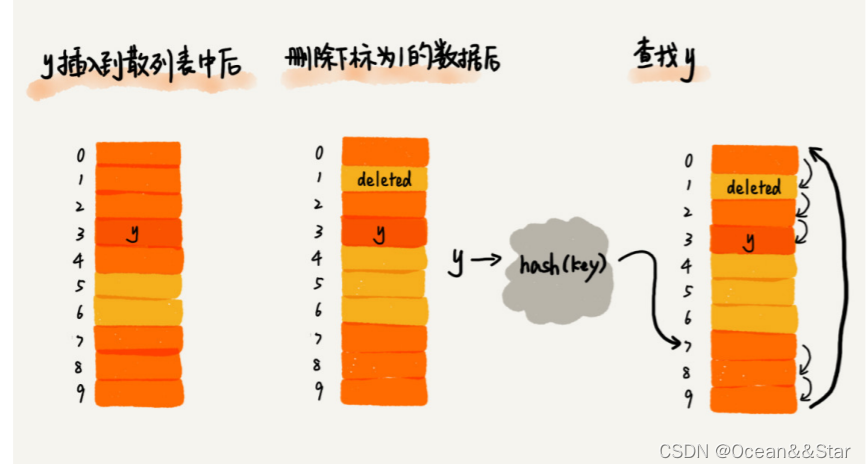

在散列表中删除一个数据:

- 对于使用线性探测法解决冲突的散列表,删除操作稍微有点特别。我们不能单纯的把要删除的元素设置为空。这是为什么呢?

- 原因:在查找的时候,一旦我们通过线性探测的方法,找到一个空闲的位置,我们就可以认定散列表中不存在这个数据。但是,如果这个空闲位置是我们后来删除的,就会导致原来的查找算法失效,本来存在的数据,会被认为不存在。那这个问题应该如何解决呢?

- 解决:我们可以将删除的元素,特殊标记为deleted。当线性探测查找的时候,遇到标记为deleted的空间,并不是停下来,而是继续往下探测

线性探测法其实存在很大问题。当散列表中插入的数据越来越多时,散列冲突发生的可能性就会越来越大,空闲位置会越来越少,线性探测的时间就会越来越久。极端情况下,我们可能需要探测整个散列表,所以最快情况下的时间复杂度是O(n)。同理,在删除和查找的时候,也有可能会线性探测整张散列表,才能找到要查找或者删除的数据。

对于开放寻址冲突解决方法,除了线性探测方法之外,还有另外两种比较经典的探测方法,二次探测(Quadratic probing)和双重散列(Double hashing)。

二次探测

所谓二次探测,跟线性探测很像,线性探测每次探测的步长是1,那它探测的下标序列就是 h a s h ( k e y ) + 0 , h a s h ( k e y ) + 1 , h a s h ( k e y ) + 2 hash(key)+0,hash(key)+1,hash(key)+2 hash(key)+0,hash(key)+1,hash(key)+2……而二次探测探测的步长就变成了原来的“二次方”,也就是说,它探测的下标序列就是 h a s h ( k e y ) + 0 , h a s h ( k e y ) + 1 2 , h a s h ( k e y ) + 2 2 hash(key)+0,hash(key)+1^2 ,hash(key)+2^2 hash(key)+0,hash(key)+12,hash(key)+22 ……

双重散列

所谓双重散列,意思就是不仅要使用一个散列函数。我们使用一组散列函数 h a s h 1 ( k e y ) 、 h a s h 2 ( k e y ) , h a s h 3 ( k e y ) hash1(key)、hash2(key),hash3(key) hash1(key)、hash2(key),hash3(key)……我们先用第一个散列函数,如果计算得到的存储位置已经被占用,再用第三个散列函数,依次类推,直到找到空闲的存储位置

补充

不管采用哪种探测方法,当散列表中空闲位置不多的时候,散列冲突的概率就会大大提高。为了尽可能的保证散列表的操作效率,一般情况下,我们会尽可能保证散列表中有一定比例的空闲槽位。我们用装载因子来表说空位的多少

散 列 表 的 装 载 因 子 = 填 入 表 中 的 元 素 个 数 / 散 列 表 的 长 度 散列表的装载因子 = 填入表中的元素个数 / 散列表的长度 散列表的装载因子=填入表中的元素个数/散列表的长度

装载因子越大,说明空闲位置越少,冲突越多,散列表的性能会下降。

链表法

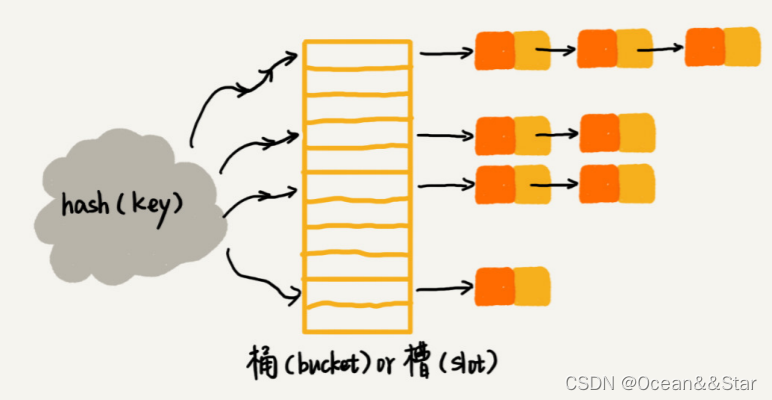

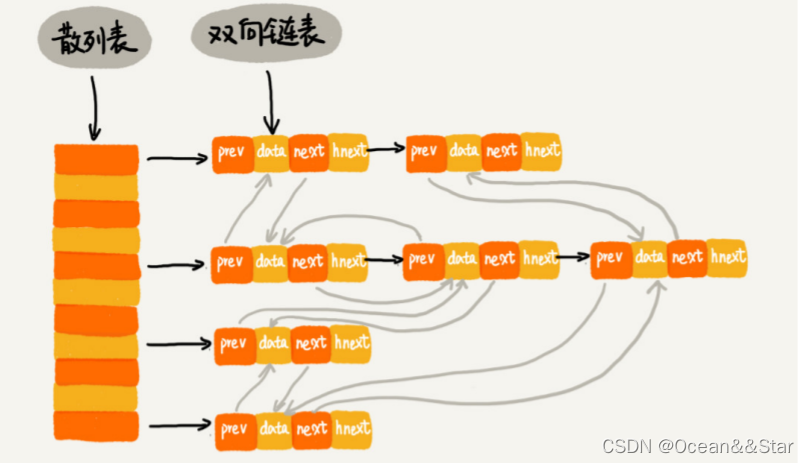

链表法是一种更加常用的散列冲突解决方法,相比开放寻址法,它要简单得多。如下图1,在散列表中,每个“桶(bucket)”或者“槽(slot)”会对应一条链表,所有散列值相同的元素我们都放到相同槽位对应的链表中

- 当插入的时候,我们只需要通过散列函数计算出对应的散列槽位,将其插入到对应链表中即可,所以插入的时间复杂度是 O(1)。

- 当查找、删除一个元素时,我们同样通过散列函数计算出对应的槽,然后遍历链表查找或者删除。那查找或删除操作的时间复杂度是多少呢?实际上,这两个操作的时间复杂度跟链表的长度k成正比,也就是O(k)。对于散列比较均匀的散列函数来说,理论上讲,k=n/m,其中 n 表示散列中数据的个数,m 表示散列表中“槽”的个数。

如何打造一个工业级水平的散列表

从上面我们可以知道,散列表的查询效率并不能笼统的说成是O(1)。它跟散列函数、装载因子、散列冲突等都有关系。如果散列函数设计的不好,或者装载因子过高,都可能导致散列冲突发生的概率升高,查询效率下降。

在极端情况下,有些恶意的攻击者,还有可能通过精心构造的数据,使得所有的数据经过散列函数之后,都散列到同一个槽里。如果我们使用的是基于链表的冲突解决方法,那这个时候,散列表就会退化成链表,查询的时间复杂度就从O(1)急剧退化为O(n)

如果散列表中有10万个数据,退化后的散列表查询的效率就下降了10万被。更直接点说,如果之前100次查询只需要 0.1 秒,那现在就需要 1 万秒这样就有可能因为查询操作消耗了大量CPU或者线程资源,导致系统无法响应其他请求,从而到达拒绝服务攻击(DoS)的目的。这也就是散列表碰撞攻击的基本原理。

那该如何设计一个可以应对各种异常情况的工业级散列表,来避免在散列冲突的情况下,散列表性能的急剧下降,并且能抵抗散列碰撞攻击?

工业级的散列表应该具有如下要求:

- 支持快速的查询、插入、删除操作;

- 内存占用合理,不能浪费过多的内存空间;

- 性能稳定,极端情况下,散列表的性能也不会退化到无法接受的情况。

从下面三个方面来考虑设计思路:

- 设计一个合适的散列函数;

- 定义装载因子阈值,并且设计动态扩容策略;

- 选择合适的散列冲突解决方法。

如何设计散列函数

散列函数设计的好坏,决定了散列表冲突的概率大小,也直接决定了散列表的性能。那什么才是好的散列函数呢?

- 首先,散列函数的设计不能太复杂。过于复杂的散列函数,势必会消耗很多计算支援,也就间接影响到散列函数的性能

- 其次,散列函数生成的值要尽可能的随机并且均匀分布,这样才能避免或者最小化散列冲突,而且即便出现冲突,散列到每个槽里的数据也会比较平均,不会出现某个槽内数据特别多的情况

- 实际工作中,我们还需要综合考虑各种因素。这些因素有关键字的长度、特点、分布、还有散列表的大小等。

设计例子:

- 第一个就是上面学生运动会的例子,我们通过分析参数编号的特征,把编号中的后两位作为散列值。我们还可以用类似的散列函数处理手机号码,因为手机号码前几位重复的可能性很大,但是后面几位计较随机,我们可以取手机号的后四位作为散列值。这种散列函数的设计方法,一般叫做数据分析法

- 第二个例子就是word拼写检测功能。这里的散列函数可以射阳设计:将单词中每个字母的ASCll 码值“进位”相加,然后再跟散列表的大小求余、取模,作为散列值。比如

hash("nice")=(("n" - "a") * 26*26*26 + ("i" - "a")*26*26 + ("c" - "a")*26+ ("e"-"a")) / 78978

实际上,散列函数的设计方法还有很多,比如直接寻址法、平方取中法、折叠法、随机数法等

装载因子过大怎么办

装载因子越大,说明散列表中的元素越多,空闲位置越少,散列冲突的概率就越大。不仅插入数据的过程需要经过多次寻址或者拉很长的链,查找的过程也会因此变得很慢

(1)对于没有频繁插入和删除的静态数据集合来说,我们很容易根据数据的特点、分布等,设计出完美的、极少冲突的散列函数,因为毕竟之前数据都是已知的。

(2)对于动态散列表来说,数据集合是频繁变动的,我们实现无法预估要加入的数据个数,所以我们也无法实现申请一个足够大的散列表。随着数据慢慢加入,装载因子就会慢慢变大。当装载因子大到一定程度之后,散列冲突就会变得不可接受。这个时候,我们该如何处理呢?

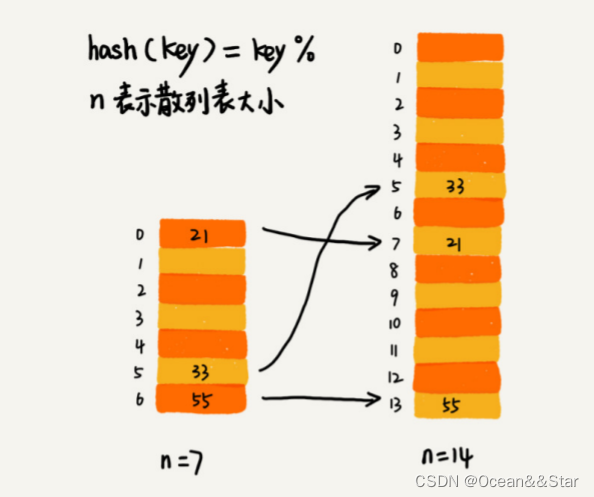

- 针对散列表,当装载因子过大时,我们可以进行动态扩容,重新申请一个更大的散列表,将数据搬移到这个新散列表中。假设每次扩容我们都申请一个原来散列表大小两倍的空间。如果原来散列表的装载因袭是0.8,那经过扩容之后,新散列表的装载因子就下降为原来的一半,变成了0.4

- 针对数组的扩容,数据的搬移操作就比较简单。但是,针对散列表的扩容,数据搬移操作要复杂很多。因为散列表的大小变了,数据的存储位置也变了,所以我们需要通过散列函数重新计算每个数据的存储位置

- 如下图,在原来的散列表中,21 这个元素原来存储在下标为 0 的位置,搬移到新的散列表中,存储在下标为 7 的位置

对于支持动态扩容的散列表,插入操作的时间复杂度是多少呢?

- 插入一个数据,最好情况下,不需要扩容,最好时间复杂度是O(1)

- 最好情况下,散列表装载因子过高,启动扩容,我们需要重新申请内存空间,重新计算哈希位置,并且搬移数据,所以时间复杂度是O(n)

- 用摊还分析法,均摊情况下,时间复杂度接近最好情况,就是 O(1)。

实际上,对于动态散列表,随着数据的删除,散列表中的数据会越来越少,空闲空间会越来越多。如果我们对空间消耗非常敏感,我们可以在装载因子小于某个值之后,启动动态缩容。当然,如果我们更在意执行效率,能够容忍多消耗一点内存空间,那就可以不用费劲来缩容了。

装载因子阈值需要选择得当。如果太大,会导致冲突过多;如果太小,会导致内存浪费严重。

- 装载因子阈值的设置要权衡时间、空间复杂度。

- 如果内存空间不紧张,对执行效率要求很高,可以降低负载因子的阈值;

- 相反,如果内存空间紧张,对执行效率要求又不高,可以增加负载因子的值,甚至可以大于 1。

如何避免低效的扩容

大部分情况下,动态扩容的散列表插入一个数据都很快,但是在特殊情况下,当装载因子已经达到阈值,需要先进入扩容,再插入数据。这个时候,插入数据就会变得很慢,甚至无法接受。

举一个比较极端的例子,如果散列表当前大小为1GB,要想扩容为原来的两倍大小,那就需要对1GB的数据重新计算哈希值,并且从原来的散列表搬移到新的散列表,那就非常耗时了。

如果我们的业务代码直接服务于用户,尽管大部分情况下,插入一个数据的操作很快,但是,极个别非常慢的插入操作,也会让用户崩溃。这个时候,“一次性”扩容的机制就不合适了。

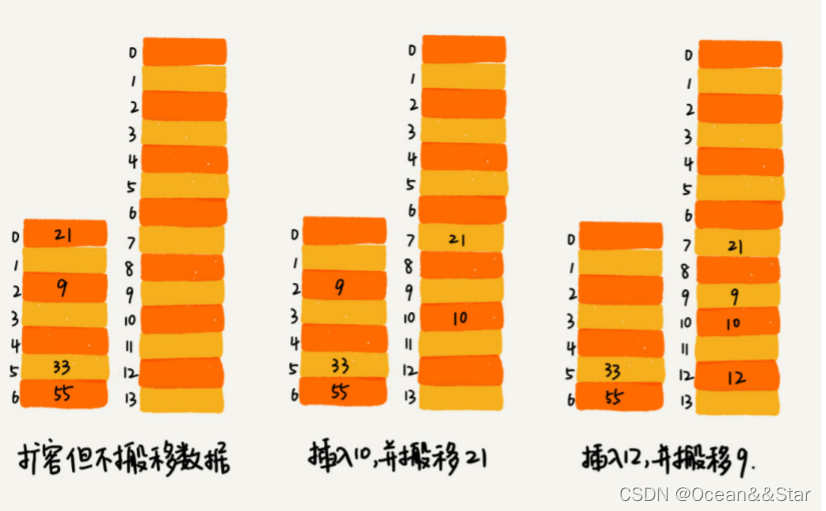

为了解决一次性扩容耗时过多的情况,我们可以将扩容操作穿插在插入操作的过程中,分批完成。装装载因子触达阈值之后,我们只需要申请新空间,但并不将老的数据搬移到新散列表中。

- 当有新数据要插入时,我们将新数据插入到新散列表中,并且从老的散列表中拿出一个数据放入到新散列表中

- 每次插入一个数据到散列表,我们都重复上面的过程。

- 经过多次插入操作之后,老的散列表中的数据就一点一点全部搬移到新散列表中了

- 这样就没有了集中的一次性数据搬移,插入操作就会的非常快了

这期间的查询查找怎么做呢?

- 对于查询操作,为了兼容新、老散列表中的数据,我们先从新散列表中查找,如果没有找到,再去老的散列表中查找。

通过这样均摊的方法,将一次性扩容的代价,均摊到多次插入操作中,就避免了一次性扩容耗时过多的情况。这种实现方式,任何情况下,插入一个数据的时间复杂度都是O(1)

如何选择冲突解决方法

散列冲突有两种解决方法,开放寻址法和拉链法。这两种冲突解决方法在实际的软件开发中都非常有用。比如,Java 中 LinkedHashMap 就采用了链表法解决冲突,ThreadLocalMap 是通过线性探测的开放寻址法来解决冲突。这两种冲突解决方法各有什么优势和劣势,有各自使用哪些场景呢?

开放寻址法

- 优点:开放寻址法不像链表法,需要拉很多链表。散列表中的数据都存储在数组中,可以有效的利用CPU缓存加快查询速度。而且,这种方法实现的散列表,序列化起来比较简单。链表法包含指针,序列化起来就没那么容易。

- 缺点:删除数据的时候比较麻烦,需要特殊标记已经删除掉的数据。而且在开放寻址法中,所有的数据都存储在一个数组中,比起链表来说,冲突的代价更高。所以,使用开放寻址法解决冲突的散列表,装载因子的上限不能太大。这也导致这种方法比链表法更浪费内存空间。

- 适用场景:当数据量比较小、装载因子小的时候,适合采用开放寻址法。这也是Java 中的ThreadLocalMap使用开放寻址法解决冲突的原因

拉链法

- 首先,拉链法对内存的利用率比开放寻址法要高。因为链表节点可以在需要的时候再创建,并不需要像开放寻址法那样事先申请好。实际上,这也是链表优于数组的地方

- 拉链法比起开放寻址法,对大装载因子的容忍度更高。开放寻址法只能适用于装载因子小于1的情况。接近1的时候,就可能会有大量的散列冲突,导致大量的探测、再散列等,性能会下降很多。但是对于拉链法来说,只要散列函数的值随机均匀,即便装载因子变成10,也就是链表的长度变长了而已。虽然查找效率有所下降,但是比起顺序查找还是快很多。

- 链表因为要存储指针,所以对于比较小的存储,是比较消耗内存的,还有可能让内存的消耗翻倍。而且,因为链表中的节点是零散分布在内存中的,不连续的,所以对CPU缓存是不友好的,这方面对执行效率也有一定的影响。当然,如果我们存储的是大对象,也就是说存储的对象的大小远远大于一个指针的大小(4 个字节或者 8 个字节),那链表中指针的内存消耗在大对象面前就可以忽略了。

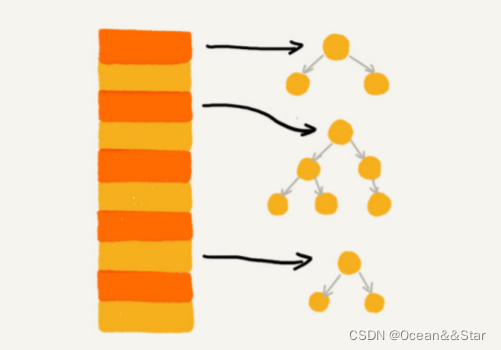

- 实际上,我们对链表法稍加改造,就可以实现一个更加高效的散列表。那就是,我们将链表法中链表改造为其他高效的动态数据结构,比如调表、红黑树。这样,即使出现散列冲突,极端情况下,所有的数据都散列到同一个桶中,那最终退化成的散列表的查找时间也只不过是O(logn)。这样也就有效避免了前面讲到的散列碰撞攻击。

- 适用场景:基于链表的散列冲突处理方法比较适合存储大对象、大数据量的散列表,而且,比起开放寻址法,它更加灵活,支持更多的优化策略,比如用红黑树代替链表。

java的hashmap分析

初始大小

HashMap默认初始大小是16,当然这个默认值是可以设置的,如果事先知道大概的数据量有多大,可以通过修改默认初始大小,减少动态扩容的次数,这样会大大提高HashMap 的性能。

装载因子和动态扩容

最大装载因子默认是 0.75,当 HashMap 中元素个数超过 0.75*capacity(capacity 表示散列表的容量)的时候,就会启动扩容,每次扩容都会扩容为原来的两倍大小。

散列冲突解决方法

HashMap 底层采用链表法来解决冲突。即使负载因子和散列函数设计得再合理,也免不了会出现拉链过长的情况,一旦出现拉链过长,则会严重影响 HashMap 的性能。

于是,在 JDK1.8 版本中,为了对 HashMap 做进一步优化,我们引入了红黑树。而当链表长度太长(默认超过 8)时,链表就转换为红黑树。我们可以利用红黑树快速增删查改的特点,提高HashMap的性能。当红黑树节点个数小于8个的时候,又会将红黑树转换为链表。因为在数据量比较小的情况下,红黑树要维护平衡,比起链表来,性能上的优势并不明星

散列函数

散列函数的设计并不复杂,追求的是简单高效、分布均匀。

int hash(Object key) { int h = key.hashCode(); return (h ^ (h >>> 16)) & (capitity -1); //capicity 表示散列表的大小} 其中,hashCode() 返回的是 Java 对象的 hash code。比如 String 类型的对象的hashCode() 就是下面这样:

public int hashCode() { int var1 = this.hash; if(var1 == 0 && this.value.length > 0) { char[] var2 = this.value; for(int var3 = 0; var3 < this.value.length; ++var3) { var1 = 31 * var1 + var2[var3]; } this.hash = var1; } return var1;} 实际应用

word文档中的单次拼写检查是如何实现的?

- 常用的英文单次有20万个左右,假设单词的平均长度是10个字母,平均一个单词占用10个字节的内存空间,那么20 万英文单词大约占 2MB 的存储空间,就算放大 10 倍也就是20MB。对于现在的计算机来说,这个大小完全可以放在内存里面,所以我们可以用散列表来存储整个英文单词

- 当用户输入某个英文单词时,我们拿用户输入的单词去散列表中查找。如果查到,则说明拼写正确;如果没有查到,则说明拼写可能有误,给予提示。借助散列表这种数据结构,我们就可以轻松实现快速判断是否存在拼写错误。

LRU缓存淘汰算法

可以通过链表实现一个LRU缓存淘汰算法

- 我们需要维护一个按照访问时间从大到小排列的链表结构。

- 因为缓存大小有限,当缓存空间不够,需要淘汰一个数据的时候,我们就直接将链表头部的节点删除

- 当要缓存某个数据的时候,先在链表中查找这个数据,如果没有找到,则直接将数据放到链表的尾部;如果找到了,我们就把它移动到链表的尾部。因为查找数据需要遍历链表,所以单纯用链表实现的 LRU 缓存淘汰算法的时间复杂很高,是 O(n)。

实际上,一个缓存(cache)系统主要包含下面这几个操作:

- 往缓存中添加一个数据

- 从缓存中删除一个数据

- 在缓存中查找一个数据

这三个操作都要涉及“查找”操作,如果单纯的采用链表的话,时间复杂度只能是O(n)。如果我们将散列表和链表两种数据结构组合使用,可以将这三个操作的复杂度都降低到O(1)具体的结构就是下面这个样子:

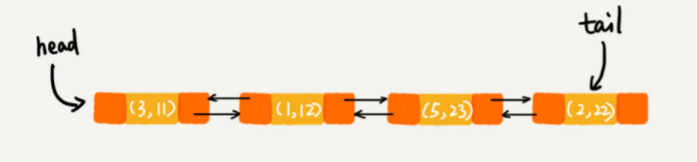

我们使用双向链表存储数据,链表中的每个结点处理存储数据(data)、前驱指针(prev)、后继指针(next)之外,还新增了一个特殊的字段 hnext。这个 hnext 有什么作用呢?

我们使用双向链表存储数据,链表中的每个结点处理存储数据(data)、前驱指针(prev)、后继指针(next)之外,还新增了一个特殊的字段 hnext。这个 hnext 有什么作用呢? - 因为我们的散列表是通过拉链法解决散列冲突的,所以每个节点会在两条链中。一个链是双向链表,另一个链是散列表中的拉链。前驱和后驱指针是为了将节点串在双向链表中,hnext指针是为了将节点串在散列表的拉链中

了解了这个散列表和双向链表的组合存储结构之后,我们再来看,前面讲到的缓存的三个操作,是如何做到时间复杂度是 O(1) 的?

- 查找一个数据:散列表中查找数据的时间复杂度接近O(1),所以通过散列表,我们可以很快的在缓存中找到一个数据。当找到数据之后,我们还需要将它移动带双向链表的尾部

- 删除一个数据:我们需要找到数据所在的节点,然后将节点删除。借助散列表,我们可以在O(1)时间复杂度里找到要删除的节点。因为我们的链表是双向链表,双向链表可以通过前驱指针 O(1) 时间复杂度获取前驱结点,所以在双向链表中,删除结点只需要 O(1) 的时间复杂度。

- 添加一个数据:必须先看这个数据是否已经在缓存中。如果已经在其中,就将其移动到双向链表的尾部;如果不在其中,还要看缓存有没有满。如果满了,则将双向链表头部的节点删除,然后再将数据放到链表的尾部;如果没有满,就直接将数据放在链表的尾部

这整个过程涉及的查找操作都可以通过散列表来完成。其他的操作,比如删除头结点、链表尾部插入数据等,都可以在 O(1) 的时间复杂度内完成。所以,这三个操作的时间复杂度都是 O(1)。至此,我们就通过散列表和双向链表的组合使用,实现了一个高效的、支持 LRU缓存淘汰算法的缓存系统原型。

redis有序集合

在有序集合中,每个成员对象有两个重要的属性,key(键值)和score(分值)。我们不仅会通过 score 来查找数据,还会通过 key 来查找数据。

举个例子,比如用户积分排行榜有这样一个功能:我们可以通过用户的 ID 来查找积分信息,也可以通过积分区间来查找用户 ID 或者姓名信息。这里包含 ID、姓名和积分的用户信息,就是成员对象,用户 ID 就是 key,积分就是 score。

所以,如果我们细化一下 Redis 有序集合的操作,那就是下面这样:

- 添加一个成员对象

- 按照键值来删除一个成员对象;

- 按照键值来查找一个成员对象;

- 按照分值区间查找数据,比如查找积分在 [100, 356] 之间的成员对象;

- 按照分值从小到大排序成员变量;

如果我们仅仅按照分值将成员对象组织成调表的结构,那按照键值来删除、查询成员对象就会很慢。解决方法与LRU缓存淘汰算法的解决方法类似。我们可以再按照键值构建一个散列表,这样按照key来删除、查找一个成员对象的时间复杂度就变成了 O(1)。同时,借助跳表结构,其他操作也非常高效。

实际上,Redis 有序集合的操作还有另外一类,也就是查找成员对象的排名(Rank)或者根据排名区间查找成员对象。这个功能单纯用刚刚讲的这种组合结构就无法高效实现了

Java LinkedHashMap

HashMap底层是通过散列表这种数据结构来实现的。而 LinkedHashMap 前面比 HashMap 多了一个“Linked”,这里的“Linked”是不是说,LinkedHashMap 是一个通过链表法解决散列冲突的散列表呢?

实际上,LinkedHashMap 并没有这么简单,其中的“Linked”也并不仅仅代表它是通过链表法解决散列冲突的。

我们先来看一段代码。

public static void main(String[] args) { HashMap m = new LinkedHashMap<>(); m.put(3, 11); m.put(1, 12); m.put(5, 33); m.put(2, 22); for(Map.Entry e : m.entrySet()){ System.out.println(e.getKey()); } }

LinkedHashMap 也是通过散列表和链表组合在一起实现的。实际上,它不仅支持按照插入顺序遍历数据,还支持按照访问顺序来遍历数据。如下:

public static void main(String[] args) { // 10 是初始大小,0.75 是装载因子,true 是表示按照访问时间排序 HashMap m = new LinkedHashMap<>(10, 0.75f, true); m.put(3, 11); m.put(1, 12); m.put(5, 23); m.put(2, 22); m.put(3, 26); m.get(5); for (Map.Entry e : m.entrySet()) { System.out.println(e.getKey()); } }

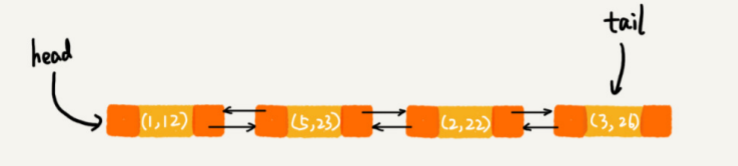

- 每次调用put函数往 LinkedHashMap 中添加数据的时候,都会将数据添加到链表的尾部。所以,在前四个操作完成之后,链表中的数据是下面这样的:

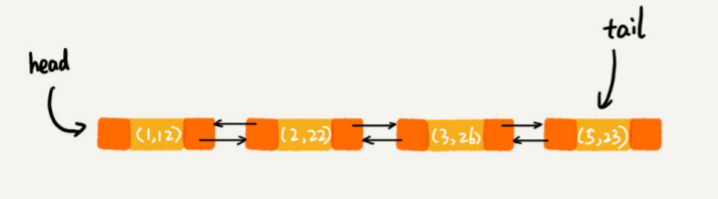

- 再次将键值为3的数据放入到LinkedHashMap的时候,会先查找这个键值是否已经有了,然后,再将已经存在的(3, 11)删除,并且将新的(3, 26)放到链表的尾部。如下:

- 当代码访问到key=5的数据时,我们将被访问到的数据移动到链表的尾部。如下:

所以,最后打印出来的数据就是1、2、3、5。从上面的分析中可以发现,按照访问的时间排序的LinkedHashMap本身就是一个支持LRU缓存淘汰的缓存系统。实际上,它们两个的实现原理也是一模一样的。

总结:LinkedHashMap 是通过双向链表和散列表这两种数据结构组合实现的。LinkedHashMap 中的“Linked”实际上是指的是双向链表,并非指用链表法解决散列冲突。

为什么散列表和链表经常一块使用

- 散列表这种数据结构虽然支持非常高效的数据插入、删除、查找操作,但是散列表中的数据都是通过散列函数打乱之后无规律存储的。也就是说,它无法支持按照某种顺序快速的遍历数据。如果希望按照顺序遍历散列表中的数据,那我们需要将散列表中的数据拷贝到数组中,然后排序,再遍历

- 因为散列表是动态数据结构,不停的有数据插入、删除,所以每当我们希望按照顺序遍历散列表中的数据的时候,都需要先排序,那效率势必会很低。为了解决这个问题,我们将散列表和链表(或者跳表)结合在一起使用。

总结

- 散列表来源于数组,它借助散列函数对数组这种数据结构进行扩展,利用的是数组支持按照下标随机访问元素的特性。散列表的两个核心问题是函数函数设计和散列冲突解决。散列冲突有两种常用的解决方法,开放寻址法和链表法。散列函数的好坏决定了散列冲突的概率,也就决定了散列表的性能

工业级水平的散列表:

- 关于散列函数的设计:我们要尽可能让散列后的值随机且均匀分布,这样会尽可能地减少散列冲突,即便冲突之后,分配到每个槽内的数据也比较均匀。除此之外,散列函数的设计也不能太复杂,太复杂就会太耗时间,也会影响散列表的性能。

- 关于散列冲突解决方法的选择:大部分情况下,链表法更加普适。而且,我们还可以通过将链表法中的链表改造成其他动态查找数据结构,比如红黑树,来避免散列表时间复杂度退化成 O(n),抵御散列碰撞攻击。但是,对于小规模数据、装载因子不高的散列表,比较适合用开放寻址法。

- 对于动态散列表来说,不管我们如何设计散列函数,选择什么样的散列冲突解决方法。随着数据的不断增加,散列表总会出现装载因子过高的情况。这个时候,我们就需要启动动态扩容。

文章目录

转载地址:https://blog.csdn.net/zhizhengguan/article/details/122417622 如侵犯您的版权,请留言回复原文章的地址,我们会给您删除此文章,给您带来不便请您谅解!

发表评论

最新留言

关于作者